2D画面を立体映像に自動生成! スタンフォード大がサービス試験提供中

2008年02月24日 19:30

アメリカのスタンフォード大学の研究チームでは、二次元(2D)の画像を自動的に解析し、三次元(3D)に見せるシステム【Make3D】を無料公開している。一定の制限があるが、誰でもその技術を実際に投稿し、確かめることができる。

アメリカのスタンフォード大学の研究チームでは、二次元(2D)の画像を自動的に解析し、三次元(3D)に見せるシステム【Make3D】を無料公開している。一定の制限があるが、誰でもその技術を実際に投稿し、確かめることができる。

スポンサードリンク

まずは実際にどのようなものか、公式サイトにデータサンプルとして上げられている動画を見て欲しい。

公式サイトに投稿されているサンプル。最初に表示されている静止画をこのシステムで変換すると、擬似立体データとして閲覧することができる。

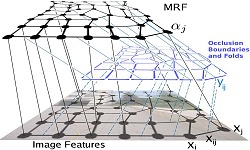

技術的な資料は【資料公開ページ】にリリースがあるが、投稿された2Dの画像を自動的に小さなパーツの集合体に分析(要はポリゴン化)、その上で各パーツ(を構成するフレーム部分)の位置関係を確認しながら立体的に見えるような画像を精製するMarkov Random Field (MRF)という技術を用いている。2005年から開発が始められ、現在はこのような形でシステムを公開し、実証実験と精度向上のためのデータ取得の段階にあるようだ。

技術的な資料は【資料公開ページ】にリリースがあるが、投稿された2Dの画像を自動的に小さなパーツの集合体に分析(要はポリゴン化)、その上で各パーツ(を構成するフレーム部分)の位置関係を確認しながら立体的に見えるような画像を精製するMarkov Random Field (MRF)という技術を用いている。2005年から開発が始められ、現在はこのような形でシステムを公開し、実証実験と精度向上のためのデータ取得の段階にあるようだ。

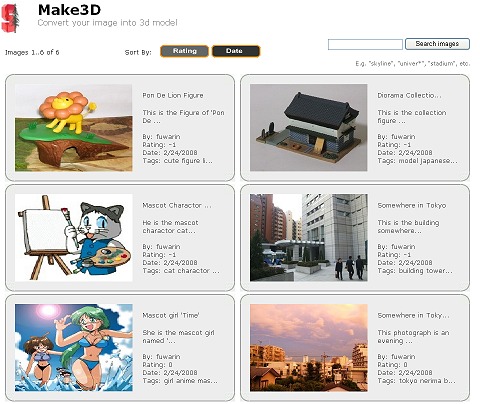

投稿された画像は動画投稿サイトのように各投稿者のアカウント毎、名前やタグ毎に分類される。そしてプラス・マイナスの評価を他人から受け、レーティングされる機能もある。投稿してから3Dデータ化されるまでには(時間帯によっても差があるが)10分~30分ほどかかる模様。

アカウント基本画面。自分が投稿した画像を確認可能。

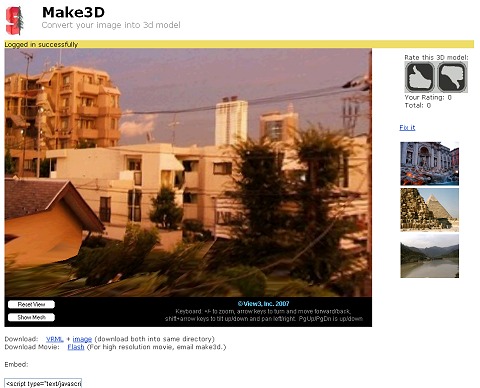

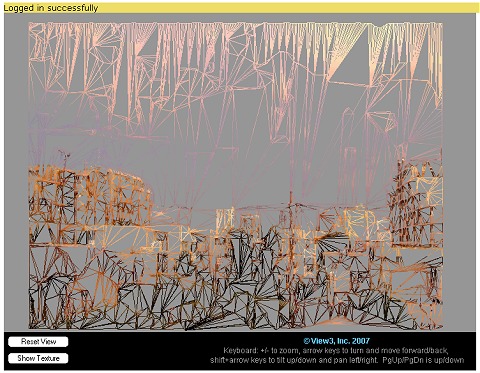

投稿され、3D化されたデータは公式サイト上ではAdobeのShockwave Playerを用いて展開される。こちらはキーボードの+と-で拡大縮小、カーソルキーで移動、カーソルキーとシフトキーの同時押しで絵そのものを回転させる形で移動することが出来る。建物の写真などなら、まるでその建物の中を歩いているような感覚におちいるわけだ。

また、YouTubeなどの動画サイト同様に、ブログパーツも用意されているし、精製された3D動画をそれっぽく見せるためのデモフラッシュのファイルも取得することができる。

精製された擬似3D画像はカーソルキーなどで移動できる。

実際はこのようにポリゴン(フレーム)で細かくデータ化され、それを計算に基づいて「ぐりぐりと」移動させている。

投稿したデータはこのようにブログパーツ形式にして抽出することも。

元々見えない部分をデータから推測して立体化することもあり、得手不得手がある。最初に掲載した動画のように、元々立体的、あるいはそれに近いもので、手前から奥に向かって緩やかな奥行きがある対称的な絵は立体化しやすい。逆に元々平面なもの(アニメや漫画のような絵図)はポリゴン化する際に無理が生じるのか、少しの移動で大きなゆがみが生じ、立体的なものには見えにくい。

先日紹介した「ポン・デ・ライオン」のフィギュア写真。これはまだ立体視できそう。

知っている人は知っている、かつて某所で使われていたイメージキャラクタたちのイラストを3D化に精製……したのだが、どうもうまく3Dに見えない。やはり元々平面のものは難しそうだ。……誰ですか、女性の写真を入力して、お尻を見たいとか言ってるのは(笑)

また、データそのものの問題からか、視点を反対側に移動し、後ろから入力したデータを眺める(推測する)こともできないようだ。

現在無料アカウントで投稿できるのは6画像まで。それ以上は他の投稿に評価を行なうなど、積極的なテストへの参加をすることで上限が増えるもよう。

技術的に解決すべき点もあるが非常に面白い仕組みに変わりは無い。将来実用化できるまでに精度が高まった際、どのような商品やサービスに活用されるのか、想像することも楽しそうである。

(Special thanks to 匿名希望さん)

スポンサードリンク

ツイート

最新情報をRSSで購読する

最新情報をRSSで購読する